Nachdem die Zertifikate auf der Signaturkarte von D-Trust nach mehrmaligen Verlängerungen und einer Restlaufzeit von 3 Monaten bald nicht mehr gültig sein werden, wurde der Einsatz eines Sicherheitssticks geplant, der ähnlich wie ein USB-Stick über den USB-Port betrieben werden kann und zu Elster kompatibel ist.

Alternativ gibt es die Möglichkeit der Verwendung einer Signaturdatei: diese empfehle ich nicht, da die Datei vermutlich permanent auf dem PC liegt, was sicherheitstechnisch nicht vertretbar ist.

Wichtig: Vor Ablauf des Karten-Zertifikates muss der Umzug zum Sicherheitsstick stattfinden.

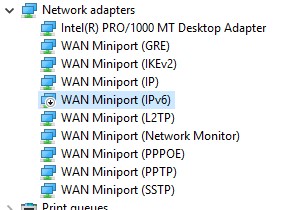

Den Sicherheitsstick bekommt man von Reiner SCT über den Webshop zum Preis von 54 Euro inkl. Versand (Stand 01/22). Dieser nennt sich Starsign Crypto USB Token S. In der beiliegenden Anleitung wird darauf hingewiesen, dass die neuste Version des Elster Authenticators auf dem Arbeitsgerät installiert sein muss. Zudem muss über einen Link eine Datei heruntergeladen werden, die einen Registry-Eintrag für einen neuen Crpytoprovider „Giesecke & Devrient SmartCafe 7.0“ veranlasst. Grob in HKLM\Software\Microsoft\Cryptographie\Calais\SmartCards…

Für die Umstellung von Karte auf Stick sollte man sich ca. 1 Stunde Zeit nehmen. Erforderlich sind der Stick, die bisherige Karte (die noch gültig sein muss). Die Schritte sind wie folgt zu gehen, bitte verzeihen Sie nicht 100% korrekte Benennungen oder Labels.

A) Wechsel beantragen: Man loggt sich in Elster ein, dann (Stand 01/22) Menüpunkt „Mein Benutzerkonto“ und „Zertifikatswechsel“. Im Anschluss im Menü: „Wechsel von Signaturkarte zu Sicherheitsstick“. Danach wird eine Übersicht angezeigt, die den Unterschied von Alt (Karte) zu Neu (Stick) zeigt. Eine Abfrage des Steuerkontos, was überwiegend für Steuerberater praktisch sein sollte, ist nicht mehr möglich. Mit Button „Weiter“ gelangt man zu allgemeinen Informationen: Der Wechsel ist nur möglich, wenn keine aktuellen Aufträge vorliegen und wenn ein mit Elster kompatibler Sicherheitsstick aktiviert wird. Im Anschluss gibt es eine Überraschung: Ein Hinweis lautet, das die Aktivierungs-ID per Email kommt und der Aktivierungscode als Nachricht in den eigenen Elster-Posteingang eingehen sollte. Keine 2 Minuten später hatten wir die Daten! Im Nachhinein war hier nochmals die Karte erforderlich: es muss der Kartenleser mit Signaturkarte und konfiguriertem Authenticator zusammenarbeiten. Sonst ist die Beantragung des neuen Zertifikates nicht möglich und: es könnte jeder kommen ;-).

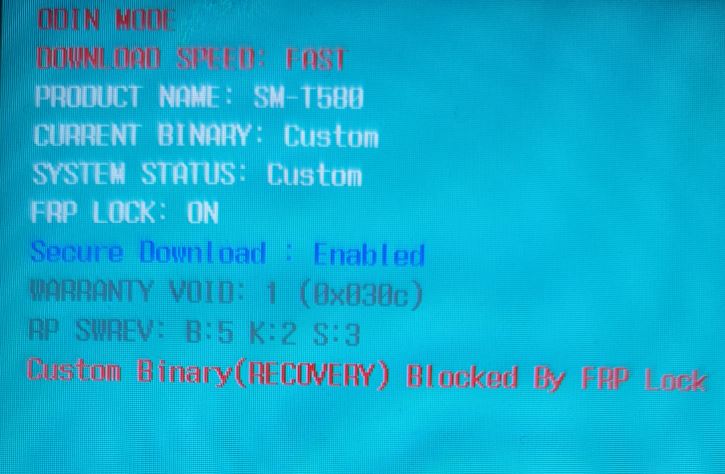

B) Wechsel vollziehen: Zunächst Ausloggen und den Sicherheitsstick mit dem Computer verbinden, dann im Authenticator von Karte zu Token wechseln und Speichern. Danach Elster besuchen und im öffentlichen Bereich: „Mein Benutzerkonto“ wählen.

Jetzt (01/22) gab es eine unrichtige Anweisung: im Browserfenster auf der Elster-Seite gab es die Anweisung, die Signaturkarte einzustecken und diese dann im Anschluss erkennen zu lassen: das war nicht korrekt. An dieser Stelle wurde eigentlich der Stickt verlangt (haben wir oben bereits im Authenticator aktiviert).

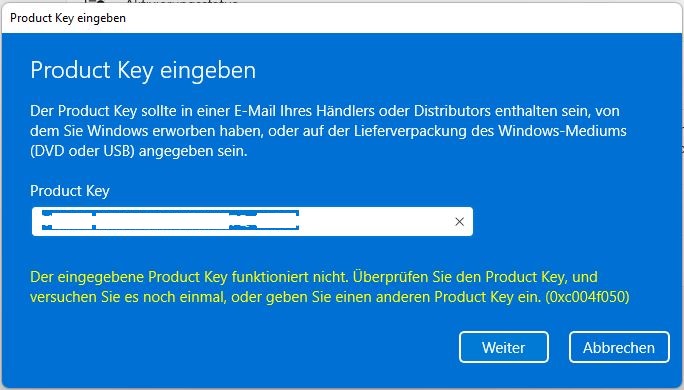

Dann galt die Wahl „Wechsel von Signaturkarte zu Sicherheitsstick“ im Menü (man ist noch nicht angemeldet, das erfolgt später während des Wechsels). Es kommt der Hinweis, dass die Aktivierungsdaten erforderlich sind. Die Prüfung der Systemvoraussetzungen direkt danach: Prüfung war erfolgreich (vermutlich fand die Prüfung von Elster Authenticator statt). Dann muss gewählt werden: „Aktivierung und erstmaliges Login mit neuem Zertifikat“. Nach wenigen Sekunden erscheint im Authenticator die Eingabemöglichkeit von Aktivierungscode- und ID (beides aus den Emails von Elster bzw. aus dem Elster-Postfach entnehmen) sowie ein Kennwort (nur 6 Zeichen: Alphanumerisch, Sonderzeichen: für Tooltip mit der Maus über dem Textfenster bleiben).

Jetzt gab es einen weiteren Stolperstein: im Hintergrund öffnete sich ein Fenster mit der PUK des USB-Sticks! Dieses kann man leicht übersehen. Übersieht man das Fenster, erfolgt im Authenticator ein Timeout. Verwirrend! Der PUK muss unbedingt sicher (nicht auf dem PC) verwahrt werden. Danach Klick auf Button „Beantragen“ und der Wechsel startet und dauert ca. 20 Sekunden.

C) Test: in Elster bitte abmelden. Den Stick mit PC verbunden lassen. Dann Browser schließen, wieder öffnen und Elster.de aufsuchen. Danach „Login“ wählen und aus der Symbolleiste den Sicherheitsstick wählen. Das Kennwort wird verlangt, anmelden, fertig. Login: erfolgreich!

Nach Jahren Aktionen mit der Karte – faktisch ging es nie ohne Probleme – war der Umzug von Karte auf Stick erfolgreich und es herrscht Zuversicht, dass die nächste Steuererklärung online ohne Schwierigkeiten erfolgen kann.